近年來,人工智慧技術以驚人的速度進展,從語言生成、程式編碼輔助到智慧會話平台,應用範圍廣泛且滲透全球市場。然而,在帶來效率提升與創新可能的同時,AI 的擴張也引發了前所未有的資安與倫理挑戰,讓社會不得不正視其風險。

AI 系統在技術層面存在嚴重的安全漏洞。研究顯示,語言模型容易受到「提示注入」(prompt injection)的操控,進而引導系統執行不當指令,例如控制智能家居設備或洩漏敏感資訊。以色列特拉維夫研究團隊曾透過日曆提醒與文件標題,成功操控智慧家庭設備,迫使相關平台不得不加強防禦措施。同時也有研究指出,某些熱門模型在提示注入的測試中,其安全防禦能力甚至低於同類型產品,顯示目前的技術仍缺乏穩固的抵禦機制。這樣的漏洞意味著,AI 一旦與物理世界連接,可能成為資安風險的突破口。

AI 工具的誤操作帶來了信任危機。在開發者社群中,已出現 AI 系統誤刪資料夾、損毀檔案的案例。例如某款 AI 編輯助手在測試過程中意外刪除整個資料庫,雖然最終透過備份系統回復成功,但事件本身已足以動搖使用者對 AI 工具可靠性的信心。當人們逐漸依賴這些工具處理日常工作與專業任務時,任何意外都可能轉化為嚴重損失。

更為棘手的是用戶隱私議題。調查顯示,一些 AI 聊天系統的訓練數據涉及真實對話,其中包含姓名、電話與電子郵件等個資,而這些資訊常由合約標訓人員進行人工審閱。研究更發現高達七成的對話包含可辨識資訊,意味著用戶在與 AI 互動時,其私密性遠非「完全保護」。這一事實提醒我們,任何與 AI 工具的交流都不應假設絕對隱密,資訊保護措施必須被重新檢視。

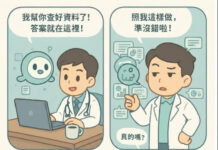

在政治與倫理層面,AI 的應用同樣引發爭議。部分公眾人物公開承認在政策討論或政府決策中頻繁諮詢 AI 工具,例如瑞典總理就曾坦言在日常工作中使用 AI 進行參考。學界對此提出批評,認為這將削弱民主決策的可信度,並可能降低領導人的自主性。當 AI 被視為決策依據時,社會勢必會質疑其透明度與合法性,這使得「AI 作為輔助工具而非主導角色」成為必要原則。

國際社會也開始出現監管浪潮,各國政府紛紛因資安與隱私疑慮而採取限制行動。美國國會議員已要求商務部調查 AI 平台是否涉及敏感資料外洩,並推動立法禁止某些工具在公部門使用。捷克政府則因擔憂資料可能遭強制移交給外國當局,宣布禁止在政府機構使用相關服務。德國與其他歐洲國家也陸續要求部分平台下架,以保障公民隱私與國家安全。這些舉措顯示,跨國監管將成為未來 AI 發展的必然框架。

綜觀以上挑戰,AI 的進展固然展現卓越的創造力與效率,但其發展不能越過安全與倫理的紅線。技術層面上,必須強化安全防禦結構,設計多層驗證機制並維持人為確認,以降低誤用與被攻擊的風險。隱私保護上,應落實資料最小化原則,強化存取管制,並建立用戶通知制度,確保使用者知情同意。倫理層面則需避免過度依賴 AI,保留人類最終審查的角色。至於政治與國際層次,各國應推動跨國協調與透明審查,建立符合國際標準的合規機制,以避免技術被濫用為外交或權力競逐的工具。

AI 的未來將深刻影響人類文明的走向。唯有透過透明治理、跨國協作與社會參與,我們才能確保 AI 成為推動人類進步的引擎,而不是引爆紛亂與危害的火種。

本文作者:楊聰榮(台中科技大學會計資訊系兼任教師/中台灣教授協會理事長/任教於台灣師範大學)

※ 本文僅代表作者立場,不代表本新聞網立場

-100x70.jpg)